|

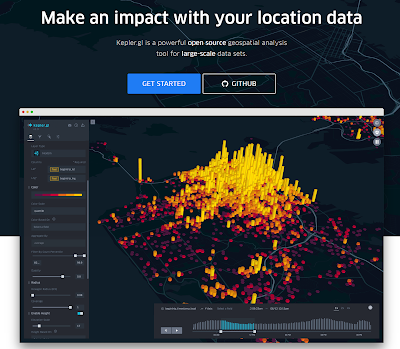

ユーザベースの分析から可視化されたインターネット上の行動ネットワーク

|

DMPを構築する上で重要なことは、ユーザを一意に識別するIDの付与基盤。これが無いとユーザベースの分析は不可能だ。もし、会員情報がとれている場合はその会員IDを用いればいい。しかし、そうした会員IDがない場合やログインしてない場合のユーザ行動を把握するには、どのようにすればよいだろうか?

現在、ユーザーIDを付与する基盤として、インティメートマージャー社のIMIDなどがある。同社には、電通なども資本を投下しており、今後成長が期待される。しかし、IMIDでサファリユーザを分析するとPV数イコールUU数となる。つまり、日本で高いシェアを持つiPhoneユーザの多くを補足できないという問題がある。理由は、アップル社がサードパーティーのクッキー利用を制限しているため、ファーストとサードパーティーのクッキーシンクがうまくできないからだ(と考えられる)。そして、その制限は、今後はさらに厳しくなることが予想される。

ではどうすべきか?発想を変えてみよう。ユーザのクッキーを取得して内部で照合するのではなく、ユーザのファーストのクッキーにIDを付与する。こうすれば、ファーストのクッキーに記録されているIDがそのままユーザを識別するIDになるため、クッキーシンクの問題は解消される。また、ファーストのクッキーにIDを付与するため、クッキーが削除されない限り、すべての閲覧行動をユーザベースで把握することができる(もちろん、アクセスログをとっていればだが)。

前職でユーザIDのインフラ化に向けた事業を一度提案したが、企業の成長ステージや規模の問題、そして、すぐに収益が上がらない点等を考慮して自ら取り下げた。しかし、個人的には将来のデータ活用の根幹を形成する極めて魅力的な事業だと思っているので、再度チャレンジしたい。

◇参考サイト

- 【ID】imidはSafariが捕捉できず、finger printはユーザの重複が多い

- 【セミナー報告】TUG (Treasure Data User Group) vol.3 - Biz Dev編

- GoogleAnalyticsのCookieは、なぜサードパーティCookieではなく、ファーストパーティCookieなのか?